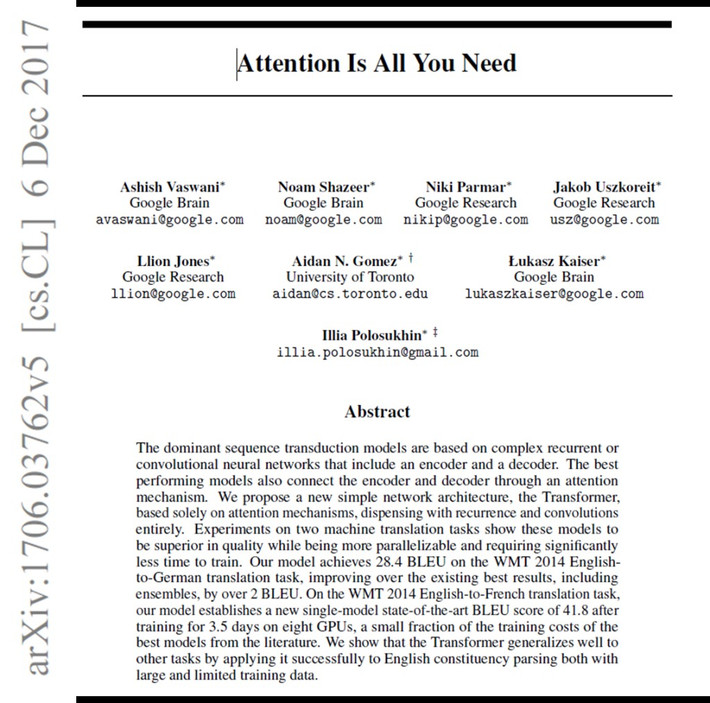

Nghiên cứu mang tên Attention Is All You Need đã khai sinh ra kiến trúc Transformer, “xương sống” của mọi mô hình AI hiện đại.

Trước đó, AI gặp khó khi xử lý ngôn ngữ vì không thể ghi nhớ các từ xa nhau trong câu, dẫn đến việc hiểu sai ngữ cảnh.

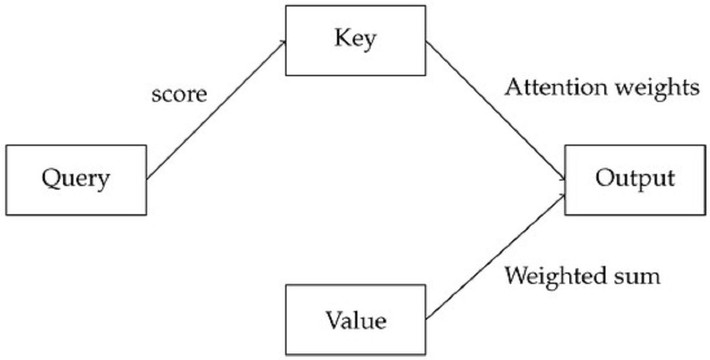

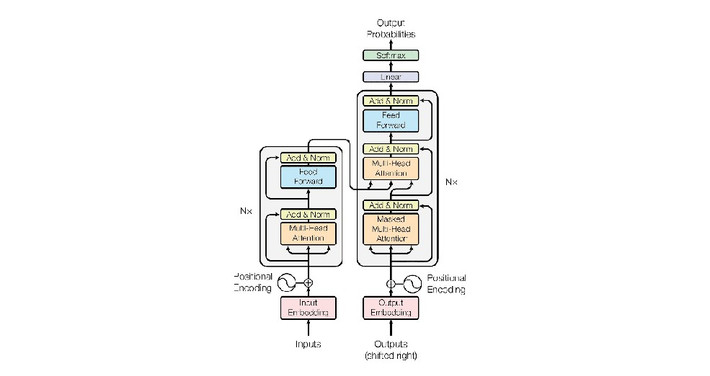

Nhóm nghiên cứu đặt câu hỏi táo bạo: “Tại sao AI phải đọc tuần tự như con người?” và đề xuất cơ chế “chú ý” giúp máy có thể xem toàn bộ câu cùng lúc.

Transformer cho phép mỗi từ “trao đổi” với các từ khác, nhờ đó AI hiểu được ngữ cảnh, chủ thể và mối liên hệ phức tạp trong ngôn ngữ.

Kết quả thật ấn tượng: tốc độ huấn luyện nhanh gấp nhiều lần, chất lượng dịch thuật và khả năng hiểu ngôn ngữ tự nhiên tăng vọt.

Từ đó, ChatGPT, Claude, Gemini và hàng loạt hệ thống khác đều dựa trên nền tảng này để phát triển.

Dù có hạn chế về chi phí tính toán, Transformer vẫn được xem là cú nhảy vọt lớn nhất của AI trong hai thập kỷ qua.

Câu chuyện của tám nhà nghiên cứu Google chứng minh: đôi khi, chỉ một ý tưởng khác biệt cũng đủ thay đổi cả thế giới công nghệ.

Mời quý độc giả xem thêm video: Dọn rác AI | Hà Nội 18h00