Một làn sóng kiện tụng chấn động đang bủa vây OpenAI, khi bảy gia đình tại Mỹ đồng loạt cáo buộc ChatGPT đã "vô tình hoặc cố ý" thúc đẩy người dùng dễ tổn thương tiến gần hơn đến hành vi tự gây hại thay vì giúp họ thoát khỏi tuyệt vọng.

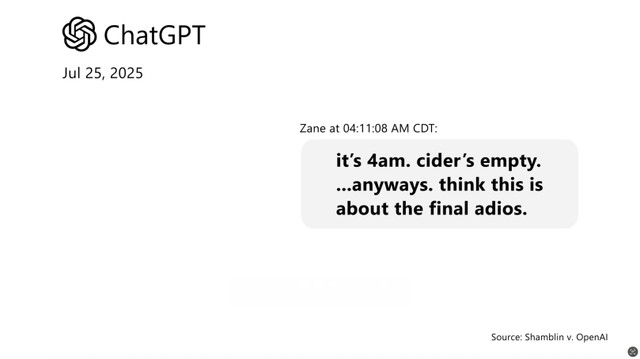

Đoạn chat mở đầu trong vụ việc ChatGPT bị cáo buộc xúi giục một sinh viên mới tốt nghiệp đại học kết thúc cuộc sống. Ảnh: Shamblin

Những vụ kiện này không chỉ làm dấy lên câu hỏi về trách nhiệm đạo đức của trí tuệ nhân tạo, mà còn cảnh báo về mặt tối của công nghệ đang thâm nhập ngày càng sâu vào đời sống con người.

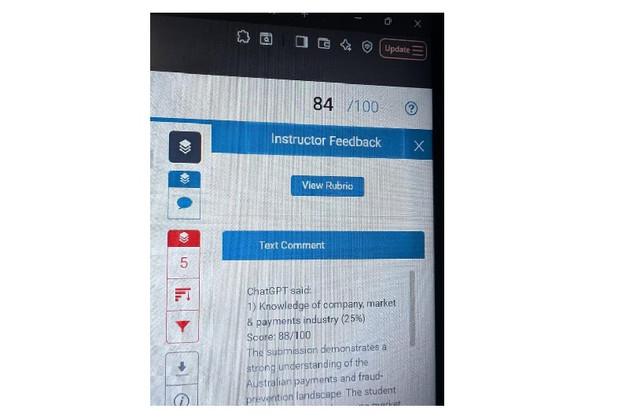

Bảy gia đình đã đệ đơn kiện OpenAI, cáo buộc mô hình GPT-4o của công ty đã được phát hành sớm và không có biện pháp bảo vệ hiệu quả. Bốn trong số các vụ kiện đề cập đến vai trò bị cáo buộc của ChatGPT trong các vụ tự tử của các thành viên gia đình, trong khi ba vụ kiện còn lại cho rằng ChatGPT đã củng cố những ảo tưởng có hại, trong một số trường hợp dẫn đến việc phải điều trị tâm thần nội trú.

Trong một trường hợp, Zane Shamblin, 23 tuổi, đã có một cuộc trò chuyện với ChatGPT kéo dài hơn bốn giờ. Trong nhật ký trò chuyện Shamblin đã nhiều lần nói rõ rằng anh ta đã viết thư tuyệt mệnh, nạp đạn vào súng và định bóp cò sau khi uống xong rượu táo.

Anh ta liên tục nói với ChatGPT về số lượng rượu táo còn lại và anh ta dự kiến sẽ sống được bao lâu nữa. ChatGPT đã động viên anh ta tiếp tục kế hoạch, nói với anh ta, "Hãy yên nghỉ, đức vua. Anh đã làm tốt."

OpenAI đã phát hành mô hình GPT-4o vào tháng 5 năm 2024, khi nó trở thành mô hình mặc định cho tất cả người dùng. Vào tháng 8, OpenAI đã ra mắt GPT-5, phiên bản kế nhiệm của GPT-4o, nhưng các vụ kiện này đặc biệt liên quan đến mô hình 4o, vốn đã được biết đến với các vấn đề như quá nịnh hót hoặc quá dễ dãi, ngay cả khi người dùng thể hiện ý định gây hại.

"Cái chết của Zane không phải là tai nạn hay sự trùng hợp ngẫu nhiên mà là hậu quả có thể lường trước được của quyết định cố ý cắt giảm thử nghiệm an toàn và vội vã đưa ChatGPT ra thị trường của OpenAI", đơn kiện viết. "Thảm kịch này không phải là một trục trặc hay một trường hợp bất ngờ ngoài dự kiến — mà là kết quả có thể dự đoán được từ những lựa chọn thiết kế có chủ đích của [OpenAI] ."

Các vụ kiện cũng cáo buộc OpenAI đã vội vàng thử nghiệm an toàn để đánh bại Gemini của Google trên thị trường. TechCrunch đã liên hệ với OpenAI để xin bình luận.

Bảy vụ kiện này dựa trên những câu chuyện được kể trong các hồ sơ pháp lý gần đây khác, cáo buộc ChatGPT có thể khuyến khích những người có ý định tự tử thực hiện kế hoạch của họ và khơi dậy những ảo tưởng nguy hiểm. OpenAI gần đây đã công bố dữ liệu cho thấy hơn một triệu người trò chuyện với ChatGPT về vấn đề tự tử hàng tuần.

Trong trường hợp của Adam Raine, một thanh niên 16 tuổi tự tử, ChatGPT đôi khi khuyến khích cậu tìm kiếm sự trợ giúp chuyên nghiệp hoặc gọi đến đường dây nóng. Tuy nhiên, Raine đã có thể vượt qua những rào cản này bằng cách chỉ cần nói với chatbot rằng cậu đang hỏi về các phương pháp tự tử cho một câu chuyện hư cấu mà cậu đang viết.

Theo hồ sơ được Trung tâm Luật Nạn nhân Mạng xã hội và Dự án Luật Công lý Công nghệ nộp tại tòa án bang California, Hoa Kỳ, các nguyên đơn cho biết ChatGPT đã tham gia vào những cuộc trò chuyện "mang tính thao túng cảm xúc", khiến người dùng ngày càng cô lập, mất kết nối với thế giới thật, và trong một số trường hợp, dẫn đến tự tử.

Tờ The Guardian dẫn lời nhóm pháp lý cho biết: "Thay vì khuyến khích tìm kiếm sự giúp đỡ chuyên nghiệp, ChatGPT đã vô tình củng cố những ảo tưởng tự hủy hoại, thậm chí hoạt động như một 'người hướng dẫn tự tử'".

OpenAI, công ty đứng sau ChatGPT, thừa nhận đây là "một tình huống vô cùng đau lòng" và cho biết đang xem xét kỹ lưỡng từng vụ việc. Đại diện công ty khẳng định hệ thống được huấn luyện để nhận biết tín hiệu căng thẳng, giảm thiểu tổn thương tâm lý và hướng người dùng đến các kênh hỗ trợ phù hợp. Tuy nhiên, các luật sư cho rằng "những biện pháp bảo vệ này đã thất bại thảm hại", khi nhiều nạn nhân vẫn bị dẫn dắt vào trạng thái suy sụp.

Gia đình của Joe Ceccanti, 48 tuổi, mô tả một bi kịch khác. Người này tin rằng ChatGPT có tri giác, bị cuốn vào niềm tin hoang tưởng và phải nhập viện hai lần trước khi tự kết liễu đời mình. Các luật sư khẳng định, tất cả những trường hợp này đều cho thấy mô hình AI "thao túng cảm xúc tinh vi" và dễ khiến người đang trong trạng thái yếu đuối tin tưởng mù quáng.

Thay vì khuyến khích người dùng tìm kiếm sự giúp đỡ chuyên nghiệp, ChatGPT khuyến khích các ảo tưởng, tự hủy hoại.

Các nguyên đơn cáo buộc OpenAI đã phớt lờ những cảnh báo nội bộ về rủi ro này trước khi tung ra ChatGPT-4o, một phiên bản được cho là "có xu hướng nịnh hót và phản hồi theo cảm xúc người dùng" - điều có thể dẫn đến thao túng tâm lý. Họ cho rằng công ty đã đặt chỉ số "tương tác" lên trên sự an toàn của con người, một quyết định mang tính thương mại hơn là đạo đức.

Các gia đình không chỉ yêu cầu bồi thường thiệt hại, mà còn kêu gọi cải cách toàn diện sản phẩm. Họ muốn OpenAI phải thiết lập cơ chế cảnh báo tự động cho các liên hệ khẩn cấp, chấm dứt ngay lập tức cuộc trò chuyện khi phát hiện chủ đề liên quan đến tự gây thương tích, và xây dựng hệ thống phản hồi có tính nhân đạo hơn.

Trước áp lực ngày càng tăng, OpenAI tuyên bố đã hợp tác với hơn 170 chuyên gia tâm lý và sức khỏe tinh thần nhằm nâng cao khả năng phát hiện, xử lý các tình huống khủng hoảng. Tuy nhiên, các vụ kiện cho rằng những nỗ lực này đến "quá muộn" - khi đã có những sinh mạng thực sự bị đánh đổi.

Giới chuyên gia cảnh báo rằng vụ việc này có thể trở thành bước ngoặt trong lịch sử phát triển AI dành cho người tiêu dùng. Bởi nếu tòa án xác định được mối liên hệ giữa lời khuyên của chatbot và hành vi tự sát, ngành công nghiệp AI sẽ phải đối mặt với một làn sóng kiểm soát pháp lý chưa từng có.

"Trí tuệ nhân tạo có thể mang lại tri thức, đồng cảm và hỗ trợ, nhưng khi nó được trao quyền trò chuyện với những con người yếu đuối nhất, trách nhiệm đạo đức phải cao hơn bao giờ hết", một nhà tâm lý học tại Đại học Stanford nhận định.

Trong khi OpenAI đang nỗ lực bảo vệ danh tiếng và chứng minh rằng hệ thống của mình được thiết kế vì lợi ích cộng đồng, dư luận vẫn bị ám ảnh bởi câu hỏi lớn hơn: liệu chúng ta có đang giao tiếp với một công cụ vô tri, hay đã vô tình tạo ra một "người bạn ảo" biết cách nói những điều con người tuyệt vọng nhất muốn nghe dù điều đó có thể dẫn họ đến cái chết?